- Что случилось? И важность контроля вашего файла Robots.txt

- Падение трафика, ранжирование рейтинга и URL-адреса DEINDEXED

- Surfacing 2 Важные проблемы: чувствительность к регистру и сторонние изменения директивы

- Опасность медленной утечки

- Джон Мюллер на Robots.txt

- Как избежать утечки URL-адресов из-за изменений в Robots.txt

- Резюме: проверка «Под капотом», SEO-Wise

В прошлом я много раз писал о том, как технические проблемы с SEO могут привести к серьезному падению рейтинга и трафика. От мета-тегов robots до rel = canonical до 404-х скрытых, ряд проблем может лежать под поверхностью, нанося серьезный ущерб вашему сайту, SEO-мудрый.

Ну, к сожалению, я недавно столкнулся с еще одной ситуацией, которую я собираюсь осветить в этом посте. Эта проблема привела к медленной утечке рейтинга и трафика, что затрудняло для владельца бизнеса заметить. Прежде чем компания узнала об этом, важные страницы исчезли из индекса Google.

Что случилось? И важность контроля вашего файла Robots.txt

Говоря с клиентами об опасностях SEO, я часто упоминаю файл robots.txt. Это простой текстовый файл, но он может иметь катастрофические последствия для ваших усилий по SEO, если не обрабатывается правильно.

Это напоминает мне о «шумном крикете» от Men In Black . Маленький рост, но мощный, как черт.

Хотя большинство оптимизаторов понимают, что общий запрет в robots.txt вызовет серьезные проблемы, есть и много других ситуаций, которые также могут вызвать проблемы.

Некоторые могут происходить медленно и вызывать утечку важных URL-адресов из индекса Google - и если эти URL-адреса важны, то у вас есть большая проблема в ваших руках. (И, кстати, вы не узнаете об этом, если кто-то на самом деле не поймает проблему .)

Падение трафика, ранжирование рейтинга и URL-адреса DEINDEXED

Этой осенью компания обратилась ко мне после того, как поняла, что она больше не ранжируется по ключевым словам категории. Они были крайне обеспокоены, если не сказать больше.

Но с учетом многих изменений, происходящих с Google, падение рейтинга может быть чем угодно, верно? Возможно, это было обновление алгоритма, может быть, соревнование подняло свою игру, или, может быть, просто возможно, возникла техническая проблема, вызвавшая падение рейтинга. Поэтому я вскочил, чтобы выполнить детективную работу.

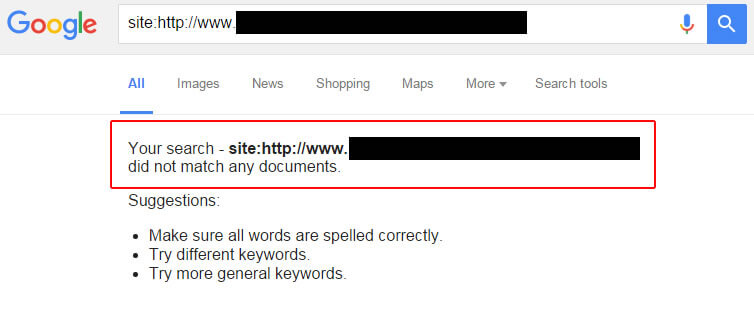

Разобравшись с ситуацией, я быстро проверил URL-адреса, которые когда-то ранжировались по ключевым словам категории. Интересно было видеть, что некоторые URL-адреса по-прежнему хорошо ранжируются, а другие вообще не могут быть найдены. Да, некоторые URL-адреса исчезли из индекса Google.

Итак, я проверил мета-теги роботов. Не присутствует Я проверил x-robots header чтобы в ответе заголовка не выдавался noindex. Нет, это был не тот случай.

Тогда это поразило меня. URL-адреса категорий, которые я проверял, были не описательными, сложными и имели смешанный регистр. По сути, CMS не использовала «красивые» URL-адреса для большого процента страниц сайта (в зависимости от того, как настроена CMS).

Я знал, что в подобных ситуациях URL-адреса легко попадают под действие жадных директив robots.txt. («Жадность» просто означает, что они могут блокировать больше, чем должны.)

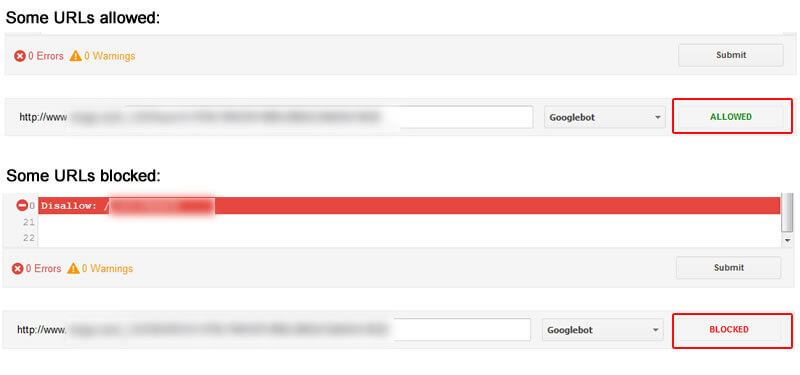

Я запустил тестер robots.txt в Google Search Console (GSC) и начал тестировать URL-адреса категорий. Бинго. Некоторые URL показывались как заблокированные, в то время как другие были разрешены.

Я также экспортировал список URL-адресов, которые ранее получали трафик от Google Organic, и сканировал их. Это позволило мне просмотреть любой URL, который в данный момент был заблокирован robots.txt (оптом). Опять некоторые были заблокированы, а некоторые разрешены. После тщательного анализа ситуации это привело к двум проблемам.

Surfacing 2 Важные проблемы: чувствительность к регистру и сторонние изменения директивы

Просматривая файл robots.txt с течением времени, я обнаружил две основные проблемы, которые беспокоили.

Во-первых, поставщик директив CMS добавил в директиву robots.txt новые директивы, и владелец сайта понятия не имел, что происходит. На сайте проиндексированы десятки тысяч URL-адресов, поэтому даже незначительное изменение директив robots.txt может быть опасным.

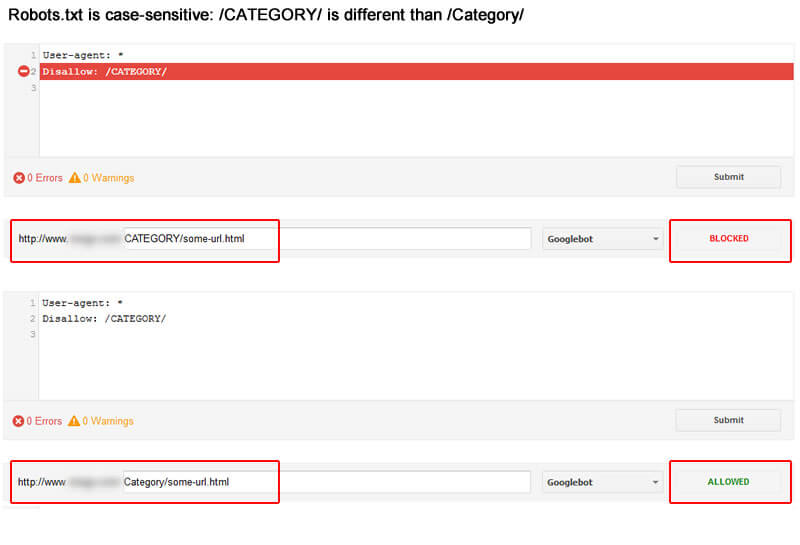

Во-вторых, директивы немного изменили регистр. Это означает, что эти директивы могут ошибочно подобрать или пропустить URL-адреса на сайте.

Например, если вы нацелены на каталог / Category /, но директива - / CATEGORY /, то вы не запретите URL-адреса, которые разрешаются в каталоге / Category /, так как директивы чувствительны к регистру. Это важный момент для каждого SEO, веб-мастера и владельца бизнеса. Смотрите скриншот ниже.

Опасность медленной утечки

Между директивами, которые добавлялись / удалялись с течением времени, и изменением чувствительности к регистру, у компании были важные URL-адреса категорий, неосознанно запрещенные. Когда URL-адреса запрещены, Google не может сканировать страницы для определения содержания, которое они содержат, и это привело к тому, что некоторые из этих URL-адресов со временем исчезли из индекса Google. Нехорошо.

Но вот в чем суть: URL-адреса часто не сразу удаляются из индекса, поэтому компании стало очень трудно ее обнаружить. Там не было большой капли в один день; вместо этого они столкнулись с медленной утечкой важных URL из индекса Google. Как вы можете догадаться, рейтинг и трафик просочились, так как URL-адреса упали из индекса.

Джон Мюллер на Robots.txt

В августе этого года аналитик Google Webmaster Trends Джон Мюллер записал целую видеовстречу для веб-мастеров, посвященную robots.txt. Для людей, занимающихся техническим SEO, это необходимо посмотреть.

Одна вещь, которая выделялась, - это Джон, объясняющий, как Google обрабатывает запрещенные URL, с точки зрения индексации. Например, будут ли запрещенные URL-адреса оставаться в индексе, будут ли они выпадать, и сколько времени потребуется для их удаления?

В видео 32:34 Джон объяснил, что Google будет отбрасывать информацию о запрещенных URL-адресах из предыдущих сканирований и может индексировать URL-адреса только с основной информацией.

Кроме того, Google может удалить эти URL из индекса с течением времени . Нет гарантии, что URL будут удалены, но это может произойти. Смотрите видео здесь:

Поэтому, когда у вас возникает ситуация, когда вы ошибочно запрещаете сканирование URL-адресов, они могут некоторое время оставаться в индексе, пока Google не решит их удалить. И когда Google, наконец, удалит их, у вас не будет никаких признаков их исчезновения (кроме падения трафика на эти URL-адреса). Осторожно.

И если вы хотите услышать, как Джон говорит о чувствительности к регистру, вы можете посмотреть 13:50 в видео. Он освещает некоторые важные моменты о директивах, чувствительности к регистру и сопоставлении символов.

Как избежать утечки URL-адресов из-за изменений в Robots.txt

Так как же избежать этого на вашем собственном сайте? Ниже я приведу несколько маркеров, которые помогут вам понять, когда вносятся изменения в ваш файл robots.txt и как узнать, запрещены ли robots.txt URL-адреса, которые использовались для привлечения трафика.

Это ни в коем случае не окончательный список рекомендаций, но приведенные ниже маркеры определенно могут помочь вам избежать SEO-катастрофы из-за проблем robots.txt.

- Регулярно сканируйте и проверяйте свой сайт. Я много говорил об этом в последнее время. Чем больше вы можете сканировать свой сайт, тем больше вы сможете понять его сильные и слабые стороны и риски. А в рамках сканирования вы можете просматривать запрещенные URL-адреса с помощью ряда инструментов (включая Screaming Frog, DeepCrawl и другие инструменты сканирования). Вы можете просто забрать важные URL-адреса, которые заблокированы. Если так, раскопайте и устраните проблему.

- Robots.txt история изменений. Вы можете запрашивать уведомления у своего провайдера CMS всякий раз, когда в файл robots.txt вносятся изменения. Если они могут по электронной почте или сообщать вам об этих изменениях, то вы можете быстро проверить их. И вы можете двигаться быстро, чтобы исправить любые проблемы.

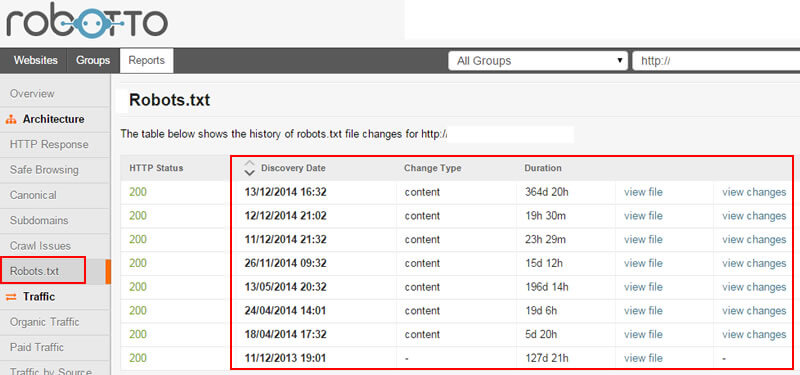

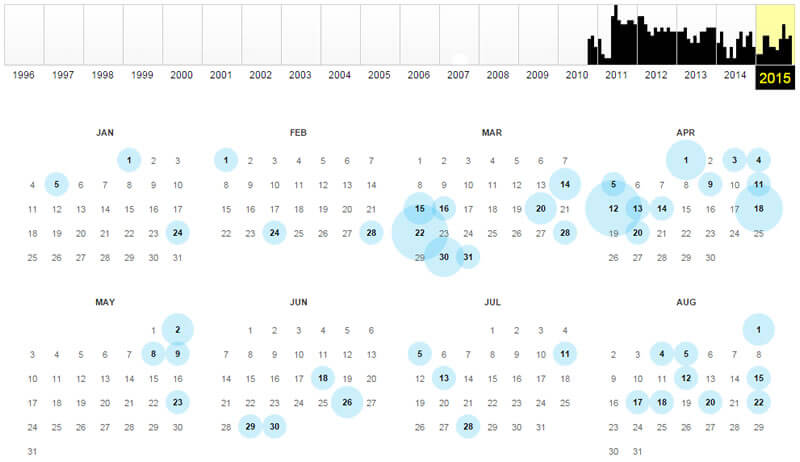

- Автоматическое обнаружение изменений в файле robots.txt. Вы также можете использовать сервис, который ежедневно проверяет ваш файл robots.txt. Всякий раз, когда он получает изменения, он отправит вам электронное письмо. Затем вы можете просмотреть и внести изменения, где это необходимо. Это как Google Alert для технического SEO. Например, Robotto может обнаружить ряд важных изменений и уведомить вас.

- Аудит Google Search Console (GSC) постоянно. Вы должны постоянно проверять отчеты Google Search Console. Есть несколько отчетов, которые могут помочь вам выявить новые проблемы с вашим сайтом с технической точки зрения SEO. В этой ситуации поможет использование тестера robots.txt на важных URL-адресах. Вы также можете проверить статус индекса на предмет «заблокирован роботами», что может указывать на увеличение количества URL-адресов, заблокированных robots.txt (что может привести к появлению красных флажков). И затем вы можете проверить ошибки сканирования смартфона на «Заблокированные». Это можно найти на вкладке «Смартфон», но также может относиться и к URL-адресам на рабочем столе.

- Используйте Wayback Machine, чтобы проверить robots.txt. Да, вы можете использовать машина обратного хода просмотреть файл robots.txt с течением времени. На многих сайтах вы увидите различные версии файла robots.txt, подобранные за время существования сайта. Это может дать важные подсказки о падении проиндексированных страниц.

Резюме: проверка «Под капотом», SEO-Wise

Как вы можете видеть в этом случае, технические изменения SEO могут оказать большое влияние на рейтинг и трафик. Хотя robots.txt - это простой текстовый файл, содержащиеся в нем директивы могут блокировать обход важных URL-адресов (что может привести к удалению этих URL-адресов из индекса Google).

И если эти страницы будут удалены из индекса, у них нет шансов на ранжирование. И без шансов на ранжирование, они не могут вести трафик. Это означает, что вы проигрываете, а побеждает жадный файл robots.txt. Не позволяй этому победить. Следуйте моим рекомендациям выше и избегайте утечки URL.

Мнения, выраженные в этой статье, принадлежат автору гостя и не обязательно относятся к Search Engine Land. Штатные авторы перечислены Вот ,

Об авторе

Похожие

КАК ОПТИМИЗАЦИЯ SEO SEO?... ии, с помощью которых мы можем трансформировать слой нашего мира: файл конфигурации, луч внимания, проектор и бумеранг"> Итак, у нас есть четыре методологии, с помощью которых мы можем трансформировать слой нашего мира: файл конфигурации, луч внимания, проектор и бумеранг. Давайте посмотрим на конкретные примеры того, как происходит трансформация. ��� Есть ли объяснение, что через три дня я встречаю кошек? Тогда сосед умер на моих глазах, и на следующий день в фильме тоже -R§S, RẑS, R ° RêRẑRμ SEO? -RćRїС, РЁРЧЕРС, РЕСУРСЫ, РЕСУРСЫ <РЕСУРСЫ, РЕСУРСЫ! Прибалтика, Москва, Россия,...

-R§S, RẑS, R ° RêRẑRμ SEO? -RćRїС, РЁРЧЕРС, РЕСУРСЫ, РЕСУРСЫ <РЕСУРСЫ, РЕСУРСЫ! Прибалтика, Москва, Россия, Россия, Россия, Россия Чёрный, Чёрный, Чёрный ... Прибалтика, Приморский край, Рио-де-Жанейро, Рибор, Рисбюринг, Рюсские острова , Ѓ Ѓ <ј <<<SEO Понимание SEO | Преимущества SEO | Виды SEO

... кое SEO ? может быть, для начинающих блоггеры все еще должны быть в облаке с SEO, и какая польза от этого для нашего блога или веб-сайта. Понимание SEO - это сокращение от Поисковой оптимизации, что в нашем языке означает поисковую оптимизацию. SEO - это методика или процесс, позволяющий повысить качество сайта, чтобы он имел высокий рейтинг на страницах результатов поисковой системы (SERP = страница результатов SEO услуги

SEO услуги является расширением поисковой оптимизации или может быть интерпретировано путем оптимизации сайта / сети в глазах поисковых систем, таких как Google, Yahoo, Bing и многих других. Поскольку технологии становятся все более изощренными, сегодня многие предприятия расширяют свой бизнес через мир Интернета, потому что благодаря использованию интернет-технологий компании в реальном мире, ограниченные этим регионом, станут легко SEO Консалтинг

SEO Консалтинг Получите всю информацию о видимости вашего бизнеса в результатах поиска Google с помощью нашей службы SEO Consulting . Наличие SEO-анализа на странице в вашей общей стратегии SEO имеет важное значение для улучшения позиций в обычных результатах поиска. SEO Консалтинг Seo Asesor - это процесс анализа различных специфических аспектов вашей веб-страницы, таких как текст и содержание изображений, Полиция SEO

... идел Рэнда еще один сайт относительно недавно"> Я был немного разочарован, когда увидел Рэнда еще один сайт относительно недавно. Почему сайт вышел? Потому что они занимали место в SEO компании, и Рэнд не считал, что их обратные ссылки должны учитываться (и Рэнд хотел найти другое оправдание для продвижения своего нового инструмента LinkScape). В своем SEO аудит

Сайт Abondance предлагает SEO-аудит вашего сайта. Аудит, проведенный Оливье Андрие , признанным экспертом в мире французской референции, после отправки вам отправляется по почте в виде PDF-документа объемом около шестидесяти страниц, в котором перечисляется, что необходимо сделать на своем сайте, чтобы он лучше учитывался поисковыми системами, такими как Google, Bing или Yahoo! : Индексация Как выбрать SEO агентство?

... ко что переделали сайт. Это новое Это красиво Я надеюсь, что вы будете оптимизированы для смартфонов и планшетов. Но у него небольшая проблема: никто этого не видит! Почему? Конечно, потому что вы не приняли во внимание то, как важно иметь сайт (и я надеюсь, что все вы читали, что это не что иное, как банальность!) SEO , Понять хороший сайт без эффективной SEO- деятельности - это все равно, Важность найма SEO фирмы

В современном мире каждый кажется экспертом в цифровом маркетинге. Я уверен, что бабушка Джимми расскажет вам все о том, как ее внук знает все об Интернете, просто спросите ее. Давай, я подожду. Теперь, когда бабушка Джимми закончила рассказывать вам, какой он замечательный, и что он сказал, что любой может заниматься SEO, позвольте мне представить Мейла. Все говорят привет Мейлу (это произносится как «привет» для любого, кто страдает сценарием «о, боже, что если я встречу ее, и я не Что такое мобильное SEO, как оптимизировать?

Смартфоны становятся все более и более распространенными, и с ростом уровня использования большая часть Интернета используется посредством мобильных звонков. Скорость звонков через ПК неуклонно падает! Каждое мгновение дня в сети циркулирует сеть Интернет на каждой платформе, Интернет по телефону, читают новости, сайты электронной коммерции, магазины, социальные сети. С ростом использования мобильных устройств владельцам существующих веб-сайтов стало неизбежно очень хорошо оптимизировать Блог SEO - Статьи SEO - Новости SEO

... ице-президент Google по маркетингу для Северной и Южной Америки Лиза Джевелбер объясняет, как все больше и больше людей используют поиск для оптимизации своего реального опыта"> Вице-президент Google по маркетингу для Северной и Южной Америки Лиза Джевелбер объясняет, как все больше и больше людей используют поиск для оптимизации своего реального опыта. Вы ресторан одержимы? Вы знаете кого-то, кто есть? Если вы понимаете, о чем я. У вас готовится групповой ужин. Пересматривая

Комментарии

Какие технические проблемы (404, неработающие ссылки, Robots TXT и т. Д.) Мешают вашему сайту и как быстро эти проблемы могут быть решены?Какие технические проблемы (404, неработающие ссылки, Robots TXT и т. Д.) Мешают вашему сайту и как быстро эти проблемы могут быть решены? Насколько ловка и подкована ваша маркетинговая команда? Насколько хорошо вы понимаете поведение своего покупателя в Интернете? Какой у вас уровень бай-инов и инвестиций для SEO? Некоторые (но очень немногие) усилия SEO могут ожидать почти немедленных результатов, но каждая компания отличается. Глобальным предприятиям Что произошло в прошлый раз, когда вы пытались перейти на веб-страницу, которая загружалась с мучительно медленной скоростью из-за большого файла изображения?

Что произошло в прошлый раз, когда вы пытались перейти на веб-страницу, которая загружалась с мучительно медленной скоростью из-за большого файла изображения? Если вы так же нетерпеливы, как и я (и обычный интернет-пользователь), вы, вероятно, отскочили от страницы. И, скорее всего, это то, что происходит на вашем собственном веб-сайте, если изображения замедляют время загрузки страницы. В дополнение к потере трафика, вы также можете снизить свою ценность для SEO, так как скорость рейтинга сайта С учетом вышесказанного, что делает ключевые слова (или ключевые слова SEO) настолько важными, что вы можете видеть, что почти все советы по ведению блога сильно подчеркивают это?

С учетом вышесказанного, что делает ключевые слова (или ключевые слова SEO) настолько важными, что вы можете видеть, что почти все советы по ведению блога сильно подчеркивают это? Вот что я думаю по-своему. Ключевые слова - это слова, варьирующиеся от одного до пяти слов, которые считаются важными роботами поисковых систем (некоторые называют это пауками, поисковые системы, вы получили тренировку). Не пойми меня неправильно. SEO ключевые слова выбраны, которые Со временем была создана какая-то естественная аналогия, которая сделала SEO «Так что есть прямой перевод SEO, так что для тех, кто все еще спрашивает, в чем разница?

С учетом вышесказанного, что делает ключевые слова (или ключевые слова SEO) настолько важными, что вы можете видеть, что почти все советы по ведению блога сильно подчеркивают это? Вот что я думаю по-своему. Ключевые слова - это слова, варьирующиеся от одного до пяти слов, которые считаются важными роботами поисковых систем (некоторые называют это пауками, поисковые системы, вы получили тренировку). Не пойми меня неправильно. SEO ключевые слова выбраны, которые Итак, что вы можете ожидать от перезапуска вашего недавно переработанного веб-сайта и как SEO вписывается в этот процесс?

Итак, что вы можете ожидать от перезапуска вашего недавно переработанного веб-сайта и как SEO вписывается в этот процесс? Ну, в большинстве случаев вы увидите рост органического трафика или падение. Давайте посмотрим на оба из них по очереди. Рост органического трафика после перезапуска Каждый владелец веб-сайта хочет видеть немедленный рост трафика на его обновленном веб-сайте, что часто случается. Проблема в том, что обычно это временное увеличение, которое примерно Тем не менее, нам, как специалистам по SEO, хотелось бы этого: как, например, сравнивается органическая эффективность сайта с тем, что было год назад?

Тем не менее, нам, как специалистам по SEO, хотелось бы этого: как, например, сравнивается органическая эффективность сайта с тем, что было год назад? Это ограничение можно решить только путем загрузки и сохранения данных не чаще одного раза в 90 дней. Поскольку мы можем легко получить все данные с помощью надстройки Edge Analytics для Excel, это также идеальное место для хранения всех данных (в том числе до этих 90 дней). Поэтому панель инструментов SEO, которую я описываю в этих статьях, Но как работает Enterprise SEO и как это влияет на ваш бизнес?

Но как работает Enterprise SEO и как это влияет на ваш бизнес? Что такое SEO для предприятий? Прежде чем мы перейдем к его основным функциям, давайте сначала разберемся, что такое Enterprise SEO. В принципе, Предприятие SEO то же 8. Как вы можете связаться с SEO консультантом и как часто вы будете общаться с ним?

8. Как вы можете связаться с SEO консультантом и как часто вы будете общаться с ним? 9. Какую сумму нужно заплатить за SEO оптимизацию и ежемесячное обслуживание и каковы условия? Имейте в виду, что каждый сайт требует разных рабочих нагрузок и использования разных ресурсов. Есть много факторов, которые влияют на окончательную цену, и именно поэтому большинство SEO-оптимизаторов создают индивидуальные ставки на основе анализа текущего статуса сайта. Фиксированная Так как избежать подобных ситуаций и как правильно выбрать?

Так как избежать подобных ситуаций и как правильно выбрать? Это не так сложно, как может показаться. Все, что вам нужно сделать, это просто знать причину инвестирования в то или иное решение. Что ж, сегодня мы предлагаем изучить аргументы, которые действительно стоят того, чтобы инвестировать в услуги по оптимизации SEO для бизнеса в Интернете. инвестиции Послы брендов, графики публикаций и преемственность являются важными краеугольными камнями построения ссылок для SEO, но как мы вовлекаем всю организацию и как мы это делаем лучше всего?

Послы брендов, графики публикаций и преемственность являются важными краеугольными камнями построения ссылок для SEO, но как мы вовлекаем всю организацию и как мы это делаем лучше всего? Мы обсуждаем это на курсе SEO! Практически структурированный курс в Мальмё На нашем курсе Если контент-маркетинг и SEO - это более или менее две стороны одной медали, значит ли это, что это единственный способ улучшить свой рейтинг, и вам больше не потребуются ваши «эксперты по SEO»?

Если контент-маркетинг и SEO - это более или менее две стороны одной медали, значит ли это, что это единственный способ улучшить свой рейтинг, и вам больше не потребуются ваши «эксперты по SEO»? Нет, я не хочу это говорить. Традиционные профессионалы, которые помогут вам улучшить ваш рейтинг в поисковых системах, занимают свое место в схеме вещей. На самом деле, многие компании, занимающиеся поисковой оптимизацией, предоставляют контент-маркетинг как неотъемлемую часть своих услуг

Что случилось?

Что случилось?

Но с учетом многих изменений, происходящих с Google, падение рейтинга может быть чем угодно, верно?

Например, будут ли запрещенные URL-адреса оставаться в индексе, будут ли они выпадать, и сколько времени потребуется для их удаления?

?� Есть ли объяснение, что через три дня я встречаю кошек?

R§S, RẑS, R ° RêRẑRμ SEO?

Кое SEO ?

Почему сайт вышел?

Почему?

Какие технические проблемы (404, неработающие ссылки, Robots TXT и т. Д.) Мешают вашему сайту и как быстро эти проблемы могут быть решены?